Den Zugang zu Supercomputern zur Förderung der Meteorologie, des Motorendesigns und der Katastrophenvorsorge verbessern

Europas Kapazitäten im Bereich des Hochleistungsrechnens werden bald Exa-Geschwindigkeiten erreichen, mit Systemen, die leistungsfähiger sind als 1 Million der schnellsten Laptops. Dadurch werden umfassende Innovationen der nächsten Generation begünstigt. Heutige datenintensive Aufgaben wie die Wettervorhersage hängen von rechenintensiven Arbeitsabläufen ab, die Modellierung und Simulationen sowie neue Datenanalysen und große Sprachmodelle der künstlichen Intelligenz (KI) miteinander verknüpfen. Die derzeitigen Arbeitsabläufe und die dazugehörigen Instrumente, die für den Einsatz auf weniger leistungsfähigen Supercomputern konzipiert sind, müssen wahrscheinlich für diese neuen Maschinen angepasst werden. „Die Programmiermodelle und Instrumente der Anwendungen, die vielen aktuellen Arbeitsabläufen zugrunde liegen, sind unterschiedlich, daher müssen wir ihre Zusammenarbeit vereinfachen“, erklärt Rosa Badia vom Barcelona Supercomputing Center und Koordinatorin des Projekts eFlows4HPC. Das Projektteam hat seinen Ansatz „HPC Workflow-as-a-Service“ genannt, weil seine Softwarelösung, die auf einer benutzerfreundlichen Plattform gehostet wird, verschiedene Anwendungen nahtlos integriert. „Unser Ansatz – der vorher nicht möglich war – hat den Zugang zu Hochleistungsrechensystemen vereinfacht und sie auch für Laien zugänglich gemacht, wodurch die wissenschaftlichen, sozialen und industriellen Möglichkeiten des Hochleistungsrechnens weiter verbreitet werden“, sagt Badia. Bisher wurden so über 30 wissenschaftliche Veröffentlichungen sowie ein politisches Weißbuch über Naturgefahren erstellt.

Unter der Motorhaube

Im Rahmen des Projekts eFlows4HPC wurden neue Funktionen zu bestehenden Instrumenten hinzugefügt, die größere und komplexere Arbeitsabläufe im Hochleistungsrechnen sowie Spitzentechnologien wie KI und Big Data unterstützen. Das Herzstück der Lösung ist eine Reihe von Softwarekomponenten, die zusammen als Softwarepaket bezeichnet werden und auf Hochleistungsrechnen basierte Arbeitsabläufe von Anfang bis Ende implementieren. Zunächst werden die verschiedenen Anwendungen des Arbeitsablaufs – wie Simulatoren, Datenverarbeitung und Vorhersagen durch maschinelles Lernen – mit der Programmierumgebung PyCOMPSs entwickelt. Datenpipelines werden ebenso eingerichtet, um zu koordinieren, wie die Daten des Arbeitsablaufs verwaltet werden, indem diese Berechnungs- und Datenverwaltungsaspekte des Arbeitsablaufs kombiniert werden. Schließlich wird alles, was zur Ausführung der Software benötigt wird, in einer Containerdatei zusammengefasst und auf dem Hochleistungsrechensystem installiert. Nutzende können dann ihre Arbeitsabläufe über eine spezielle Schnittstelle ausführen.

Tests mit verschiedenen Nutzergemeinschaften

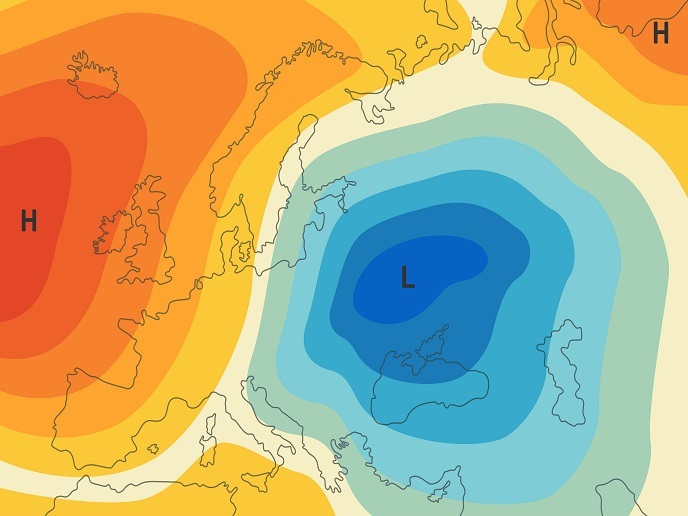

Um das Potenzial ihres Ansatzes zu demonstrieren, führte das Team drei Fallstudien mit sehr unterschiedlichen Nutzergemeinschaften durch. Der erste erstellte Anwendungsfall ist ein digitaler Zwilling von Fertigungsprozessen und Anlagen, mit dem Experimente mit verschiedenen Forschungs- und Entwicklungshypothesen kostengünstig simuliert werden können. Ein Projektpartner, CIMNE, arbeitete beispielsweise mit Siemens zusammen, um ein Modell eines Elektromotors zu erstellen, der eine Überhitzung vermeiden kann. Da diese Partnerschaft zu ermutigenden Ergebnissen geführt hat, beabsichtigt CIMNE nun die Gründung eines Spin-offs, um diese Ergebnisse zu verwerten. Das Team im zweiten Projekt befasste sich mit Erdsystemmodellierung, wobei zwei KI-basierte Arbeitsabläufe eingesetzt wurden, um die Effizienz sowohl von Erdsystemmodellen als auch von Vorhersagemodellen für tropische Wirbelstürme im Nordpazifik zu erhöhen. Diese Simulationen könnten letztlich dazu beitragen, die globalen Systeme zur Frühwarnung, Anpassung und Eindämmung zu verbessern. Da beide Arbeitsabläufe für positive Ergebnisse sorgten, werden die Erweiterungen nun im Rahmen des Projekts interTwin und der Initiative DestinE eingesetzt. Schließlich wurden (wahrscheinlich erstmals in Europa) Arbeitsabläufe zur Priorisierung des Zugangs zu Hochleistungsrechenressourcen unter der Bezeichnung „Urgent Computing“ entwickelt, um die Auswirkungen von Naturgefahren, insbesondere von Erdbeben und Tsunamis, vorherzusagen. „Dank der dynamischen Flexibilität unserer Lösung werden Erweiterungen dieser Arbeitsabläufe jetzt im Projekt DT-GEO eingesetzt, über das digitale Zwillinge physischer Systeme zur Überwachung und Vorhersage von Naturgefahren erstellt werden“, fügt Badia hinzu.

Ein Sprungbrett für Arbeitsabläufe der nächsten Generation

Das Projekt wurde mit Unterstützung des Gemeinsamen Unternehmens für europäisches Hochleistungsrechnen durchgeführt, einer Initiative, die zur Entwicklung eines Ökosystems für Hochleistungsrechnen von Weltrang in Europa gegründet wurde. Die gesamte frei zugängliche Software, die projektintern entwickelt wurde, sowie die Demonstrationsabläufe wurden frei verfügbar veröffentlicht. „Wir ermutigen jede Nutzergemeinschaft, auf die Software zuzugreifen und mit der Zusammenarbeit zu beginnen, um ihre Fähigkeiten zu erweitern“, kommentiert Jorge Ejarque, technischer Leiter von eFlows4HPC. Um den Transfer von bestmöglichen Verfahren und Ergebnissen aus dem Projekt zu gewährleisten, wurden Schulungen und Workshops in Barcelona, München und Helsinki durchgeführt. Das Team arbeitet weiterhin an der Erweiterung der Funktionen und Möglichkeiten aller Arbeitsabläufe des Projekts und konzentriert sich dabei auf KI-Systeme und digitale Zwillinge.

Schlüsselbegriffe

eFlows4HPC, Gemeinsames Unternehmen für europäisches Hochleistungsrechnen, Exa, Hochleistungsrechnen, Software, KI, digitale Zwillinge, Arbeitsabläufe, Gefahren, Fertigung, Simulatoren, Datenverarbeitung, maschinelles Lernen, Erdsystem, Datenanalytik