Mejorar el acceso a los superordenadores para impulsar la meteorología, el diseño de motores y la mitigación de catástrofes

La capacidad europea de informática de alto rendimiento (HPC, por sus siglas en inglés) pronto alcanzará velocidades de exaescala, con sistemas más potentes que un millón de los portátiles más rápidos. Ello favorecerá una gran variedad de innovaciones de vanguardia. Hoy día, las tareas que requieren un uso intensivo de datos, como las previsiones meteorológicas, dependen de flujos de trabajo con un gran volumen de cálculo, que combinan modelización, simulación y nuevos análisis de datos con modelos lingüísticos de gran tamaño basados en inteligencia artificial (IA). Los flujos de trabajo y las herramientas asociadas actuales, que se han diseñado para ser empleados en superordenadores menos potentes, quizá tendrán que adaptarse a estas nuevas máquinas. «Los modelos y herramientas de programación de las aplicaciones que subyacen a muchos flujos de trabajo actuales son diferentes, por lo que necesitamos simplificar su funcionamiento en conjunto», explica Rosa Badia, del Barcelona Supercomputing Center y coordinadora del proyecto eFlows4HPC. El equipo del proyecto ha denominado a su planteamiento «HPC Workflow-as-a-Service» (flujo de trabajo de HPC como servicio), ya que su «software», alojado en una plataforma de fácil manejo, integra eficazmente diferentes aplicaciones. «Nuestro planteamiento —que antes no era posible— ha simplificado el acceso a los sistemas HPC, lo que beneficiará a usuarios no expertos y ampliará las oportunidades científicas, sociales e industriales de la supercomputación», comenta Badia. Hasta el momento, se han elaborado más de treinta publicaciones científicas con este planteamiento, así como un libro blanco de políticas sobre riesgos naturales.

Más de cerca

En el proyecto eFlows4HPC se agregaron nuevas funcionalidades a las herramientas existentes, lo que les permite hacer frente a flujos de trabajo de HPC más grandes y complejos, y tecnologías de vanguardia como IA y datos masivos. En el corazón de su innovación se encuentra una serie de componentes de «software», conocidos en conjunto como pila de «software», que implementa flujos de trabajo de HPC, de principio a fin. En primer lugar, las distintas aplicaciones del flujo de trabajo —como simuladores, procesamiento de datos y predicciones de aprendizaje automático— se desarrollan utilizando el entorno de programación PyCOMPSs. También se configuran las canalizaciones de datos para coordinar cómo se gestionan los datos del flujo de trabajo, combinando así los procesos de cálculo y de gestión de datos del flujo de trabajo. Por último, todo lo necesario para ejecutar el «software» se encapsula en un archivo contenedor y se instala en el sistema HPC. A continuación, los usuarios pueden ejecutar sus flujos de trabajo a través de una interfaz específica.

Pruebas con diversas comunidades de usuarios

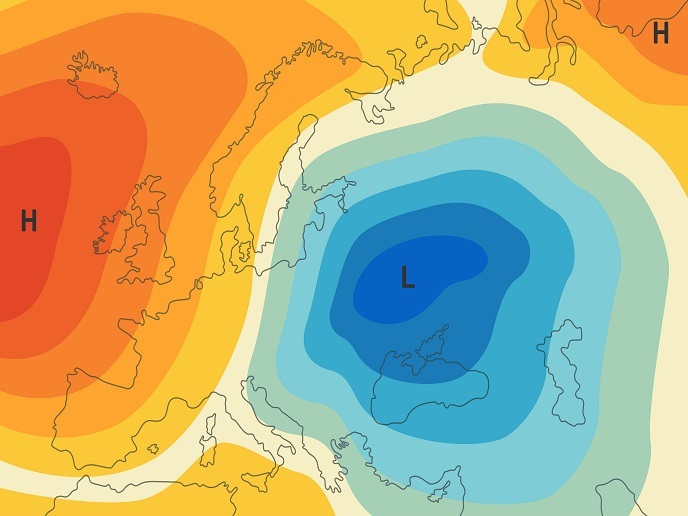

Para demostrar el potencial de su planteamiento, el equipo llevó a cabo tres pruebas de casos de uso con comunidades de usuarios muy diferentes. El primer caso práctico creado es un gemelo digital de procesos y activos de fabricación, que simula experimentos con diferentes supuestos de investigación y desarrollo de forma rentable. Por ejemplo, un socio del proyecto, CIMNE, colaboró con Siemens para desarrollar un modelo de motor eléctrico capaz de evitar el sobrecalentamiento. Esa colaboración aportó resultados alentadores, por lo que ahora el CIMNE se propone crear una empresa derivada para explotar estos logros. El segundo se centró en la modelización del sistema terrestre, utilizando dos flujos de trabajo basados en IA para aumentar la eficacia tanto de los modelos del sistema terrestre como de los modelos de predicción de los ciclones tropicales en el Pacífico Norte. En último término, estas simulaciones podrían contribuir a mejorar los sistemas mundiales de alerta rápida, adaptación y mitigación. Ambos flujos de trabajo han proporcionado resultados positivos, por lo que las extensiones ya se utilizan en el proyecto interTwin y en la iniciativa DestinE. Por último, se desarrollaron (quizá por primera vez en Europa) flujos de trabajo para priorizar el acceso a recursos de supercomputación conocidos como «computación urgente», a fin de predecir el efecto de riesgos naturales, en concreto terremotos y tsunamis. «Gracias a la flexibilidad dinámica de nuestra solución, ya se están utilizando extensiones de estos flujos de trabajo en el proyecto DT-GEO, que desarrolla gemelos digitales de sistemas físicos para supervisar y predecir riesgos naturales», agrega Badia.

Un trampolín para los flujos de trabajo de nueva generación

El proyecto se llevó a cabo con el apoyo de la Empresa Común de Informática de Alto Rendimiento Europea (EC EuroHPC), una iniciativa creada para desarrollar un ecosistema de supercomputación de categoría mundial en Europa. Todo el «software» de código abierto desarrollado en el marco del proyecto, así como los flujos de trabajo de demostración, están disponibles gratuitamente. «Animamos a cualquier comunidad de usuarios a acceder al “software” y empezar a colaborar para ampliar sus capacidades», observa Jorge Ejarque, responsable técnico de eFlows4HPC. Para garantizar la transferencia de las mejores prácticas y los resultados obtenidos en el proyecto, se organizaron cursos de formación y seminario prácticos en Barcelona, Múnich y Helsinki. El equipo sigue ampliando las prestaciones y capacidades de todos los flujos de trabajo desarrollados en el proyecto, prestando especial atención a los sistemas de IA y los gemelos digitales.

Palabras clave

eFlows4HPC, EC EuroHPC, exaescala, supercomputación, software, IA, gemelos digitales, flujos de trabajo, riesgos, fabricación, simuladores, procesamiento de datos, aprendizaje automático, sistema terrestre, análisis de datos, HPC