EYESHOTS-Projekt liefert spürbare Lösung

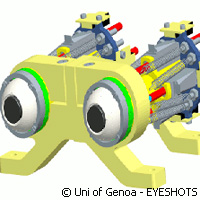

EU-finanzierte Forscher haben bei ihrem Bestreben, das Zusammenspiel von Bewegung und Sehvermögen zu steuern und menschliches Verhalten bei Robotern zu kopieren, erhebliche Fortschritte gemacht. Wie? Sie entwickelten ein ausgeklügeltes, dreidimensionales visuelles System, das mit Roboterarmen synchronisiert wurde. Das Ergebnis ist Teil des Projekts EYESHOTS ("Heterogeneous 3D perception across visual fragments"), das 2,4 Mio. EUR unter dem Themenbereich "Informations- und Kommunikationstechnologien" des Siebten Rahmenprogramms (RP7) der EU erhielt. Diese jüngste Entwicklung könnte Robotern das Sehen und somit das Wahrnehmen ihrer Umgebung lehren. Sie könnte diesen Maschinen sogar den Vorteil verschaffen, sich an den Inhalt dieser Bilder zu erinnern und entsprechend zu handeln, so die Forscher. Die Partner des EYESHOTS-Projekt unter der Leitung der Fakultät für Biophysik und Elektronik der Universität Genua in Italien mussten die grundlegenden Mechanismen eines humanoiden Roboters verfeinern, um so das erfolgreiche Zusammenspiel seiner Umgebung mit den eigenständigen Aufgaben, die er zu erfüllen hat, zu gewährleisten. Für Angel Pasqual del Pobil, Leiter des Roboterintelligenzlabors der Universität Jaume I de Castellón in Spanien, einer der EYESHOTS-Partner, bestätigte sein Team die Resultate des Konsortiums mit einem an der Universität entwickelten System. Dieses System besteht aus einem Torso mit artikulierten Armen, sowie einem Roboterkopf mit beweglichen Augen. Zu Beginn der Entwicklung studierten die Partner die Biologie von Menschen und Tieren. Als Experten für Robotik, Neurowissenschaft, Technik und Psychologie bauten sie die Computermodelle durch die Aufzeichnung von Affenneuronen, die für die visuell-motorische Koordination zuständig sind. Menschen und Primaten, so die Partner, nehmen die Welt ähnlich wahr. Die erste künstlich reproduzierte Funktion des menschlichen Sehsinns war nach Aussage des Teams unsere sakkadische Augenbewegung, die mit der dynamischen Veränderung der Aufmerksamkeit verbunden ist. "Wir verändern unsere Sichtweise kontinuierlich durch sehr schnelle Augenbewegungen, so schnell, dass wir sie kaum bemerken", erklärt Dr. Pobil. "Wenn sich die Augen bewegen, ist das Bild verschwommen und wir können nicht klar sehen. Deshalb muss das Gehirn die Fragmente wie ein Puzzle zusammensetzen und so den Eindruck eines zusammenhängenden und vollständigen Bildes unserer Umgebung schaffen." Mithilfe neuraler Daten konstruierte das Team Computermodelle des Teils des Gehirns, das Bilder mit den Bewegungen von Augen und Armen verbindet. Ihrer Ansicht nach ist dieses Model einzigartig; die Verflechtung von Bildern und Bewegungen bestätigt, dass wenn Menschen sich bewegen, um nach einem Gegenstand zu greifen, unser Gehirn die Koordinaten nicht berechnen muss. "In Wahrheit ist der Ablauf wesentlich einfacher: Unsere Augen fixieren einen Punkt und sagen unserem Arm, wohin er greifen soll", erläutert Dr. Pobil. "Babys lernen dies stufenweise durch das Verbinden von Neuronen." Kurz gesagt ist es den EYESHOTS-Partnern gelungen, diese Lernmechanismen durch ein neurales Netzwerk zu simulieren und somit Robotern beizubringen, verschiedene Aufgaben durchzuführen, u. a. ein Bild von der Umgebung zu konstruieren, die relevanten Bilder zu speichern und zu lernen, wie man guckt. Diese Roboter nutzen ihr Gedächtnis, um nach Gegenständen zu greifen, die sie zu diesem Zeitpunkt gar nicht sehen können. "Unsere Erkenntnisse können auf alle zukünftigen Roboter angewendet werden, die ihre Augen bewegen und auf einen Punkt fokussieren können", so die spanischen Forscher. "Dies sind die Hauptvoraussetzungen, damit die anderen Mechanismen korrekt funktionieren können." Die anderen Partner von EYESHOTS sind die Universität Münster in Deutschland, die Universität Bologna in Italien, sowie die Katholische Universität Leuven in Belgien.Weitere Informationen unter: EYESHOTS: http://www.eyeshots.it/ Universität Genua: http://www.unige.it/

Länder

Belgien, Deutschland, Spanien, Italien