El proyecto EYESHOTS aplica la neurociencia a la visión artificial

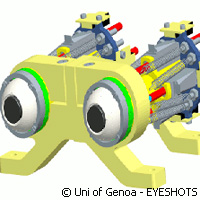

Un equipo de investigadores financiados con fondos europeos ha avanzado a pasos agigantados en sus intentos por controlar la interacción entre el movimiento y la visión con el fin de replicar en robots el comportamiento humano. Para ello desarrollaron un sofisticado sistema visual tridimensional que se sincroniza con brazos robóticos. El trabajo es fruto del proyecto EYESHOTS («Percepción tridimensional heterogénea entre diversos fragmentos visuales»), al que se adjudicaron 2,4 millones de euros a través del tema «Tecnologías de la información y la comunicación» (TIC) del Séptimo Programa Marco (7PM) de la Unión Europea. Este logro permite vislumbrar la posibilidad de construir robots capaces de ver y tomar conciencia de su entorno. Asimismo, se plantea la posibilidad de dotar a estas máquinas de la capacidad para recordar los contenidos de las imágenes vistas y actuar en consecuencia, indicaron los investigadores. Las entidades asociadas en el marco de EYESHOTS, coordinadas por el Departamento de Ingeniería Biofísica y Electrónica de la Universidad de Génova (Italia), informan que tuvieron que perfeccionar los mecanismos básicos de un robot humanoide para conseguir que interaccione con su entorno con eficacia y logre realizar tareas de manera autónoma. Según señaló Ángel Pasqual del Pobil, jefe del Laboratorio de Inteligencia Robótica de la Universitat Jaume I de Castellón (España), uno de los socios de EYESHOTS, su equipo validó los hallazgos del consorcio empleando un sistema oculomotor desarrollado por su universidad. Dicho sistema consta de un torso con brazos articulados y una cabeza robótica con ojos móviles. Los socios dieron comienzo al proceso de desarrollo examinando aspectos de la biología humana y animal. Gracias a la colaboración entre especialistas en robótica, neurociencias, ingeniería y psicología, crearon los modelos informáticos correspondientes registrando las neuronas de monos dedicadas a la coordinación visomotora, pues en palabras de los socios los humanos y los primates poseen un sistema visual semejante. La primera característica del sistema visual humano que se propusieron reproducir artificialmente fue el movimiento ocular sacádico, que según informan está relacionado con el cambio dinámico de la atención. «Constantemente cambiamos el punto de vista en unos movimientos de los ojos muy rápidos. Tanto que nosotros casi no somos conscientes», apuntó el Dr. Pobil. «Cuando los ojos están en movimiento, la imagen es borrosa y no somos capaces de percibirla nítidamente. De modo que el cerebro integra los fragmentos como si se tratase de un puzzle para darnos la impresión de una imagen continua y perfecta del entorno.» A partir de los registros neuronales, el equipo desarrolló modelos informáticos de la sección del encéfalo que integra las imágenes con los movimientos de ojos y brazos. Según sus responsables, se trata de un modelo excepcional. Gracias a la integración de las imágenes con los movimientos, cuando los humanos se mueven para alcanzar un objeto, no es necesario que el encéfalo calcule las coordenadas correspondientes. «No es que a partir de los ojos el cerebro calcule una posición y entonces el brazo se mueva a esa posición, sino que es mucho más directo: al mirar los ojos a un punto, los ojos le dicen al brazo dónde tiene que ir», explicó el Dr. Pobil. «Todo esto se va aprendiendo durante las etapas de desarrollo: los bebés no conocen esa relación pero se aprende a base de conectar neuronas.» En resumen, los socios de EYESHOTS han conseguido simular estos mecanismos de aprendizaje mediante un modelo computacional de redes neuronales, lo cual capacitará a robots para realizar diversas tareas, incluidos formarse una representación de su entorno, retener las imágenes pertinentes y aprender a mirar. Además, estos robots se podrán valer de su memoria para tratar de agarrar objetos aunque no los puedan ver. «Nuestros hallazgos se pueden aplicar a cualquier robot humanoide del futuro con capacidad de mover los ojos y enfocarlos a un punto», aseguró el investigador español. «Son cuestiones prioritarias para que los demás mecanismos funcionen correctamente.» Los demás socios de EYESHOTS son la Universidad de Münster (Alemania), la Universidad de Bolonia (Italia) y la Universidad Católica de Lovaina (Bélgica).Para más información, consulte: EYESHOTS: http://www.eyeshots.it/ Universidad de Génova: http://www.unige.it/

Países

Bélgica, Alemania, España, Italia