Le projet EYESHOTS offre une solution tactile

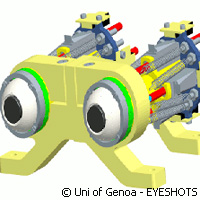

Des chercheurs de l'UE ont réalisé des pas de géants dans leur quête de contrôler l'interaction entre le mouvement et la vision, répliquant le comportement sur des robots. Comment? Ils ont développé un système visuel tridimensionnel sophistiqué synchronisé à des bras robotisés. Ce résultat s'inscrit dans le cadre du projet EYESHOTS («Heterogeneous 3D perception across visual fragments»), qui a reçu 2,4 millions d'euros au titre du thème Technologies de l'information et de la communication (TIC) du septième programme-cadre (7e PC). Ce dernier développement permettrait aux robots de voir et d'être conscients de leur environnement. Ces machines pourraient alors se souvenir du contenu d'images, ce qui leur permettrait d'agir en conséquence. Menés par le département d'ingénierie électronique et biophysique de l'université de Gênes en Italie, les partenaires d'EYESHOTS expliquent qu'ils ont du affiner les mécanismes de base d'un robot humanoïde pour assurer une bonne interaction avec son environnement pour l'accomplissement de tâches autonomes. Pour Ángel Pasqual del Pobil, responsable du laboratoire d'intelligence robotique de l'université Jaume I de Castellón, partenaire d'EYESHOTS, son équipe a validé les résultats du consortium avec un système développé à l'université. Ce système comprend un torse avec des bras articulés et une tête de robot à yeux mobiles. Les partenaires ont lancé le processus de développement en examinant la biologie humaine et animale. Experts en robotique, neuroscience, ingénierie et psychologie, les membres de l'équipe ont construit des modèles informatiques en enregistrant des neurones de singe engagés dans une coordination visuelle et motrice. Selon les partenaires, les hommes et les primates partagent la même perception du monde. La caractéristique artificielle répliquée du système visuel humain était les mouvements oculaires saccadiques associés au changement dynamique d'attention. «Nous changeons constamment de point de vue par des mouvements oculaires très rapides, si rapides qu'ils passent inaperçus», explique le Dr Pobil. «Lorsque nos yeux bougent, l'image est floue et nous ne pouvons pas voir clairement. Ainsi, le cerveau doit intégrer les fragments comme s'il s'agissait d'un puzzle pour donner l'impression d'une image continue et parfaite de notre environnement.» En utilisant les données neuronales, l'équipe a conçu des modèles informatiques de la section cérébrale qui associe les images avec les mouvements des yeux et des bras. Selon eux, ce modèle est unique; l'intégration des images avec les mouvements confirment que lorsque nous nous déplaçons pour attraper un objet, notre cerveau n'a pas besoin de calculer les coordonnées. «En réalité, la séquence est plus directe: nos yeux fixent un point et indiquent à nos bras quelle direction prendre», explique le Dr Pobil. «Les bébés apprennent cela en associant leurs neurones, de manière progressive.» En résumé, les partenaires EYESHOTS sont parvenus à simuler ces mécanismes d'apprentissage par un réseau neuronal, permettant aux robots de réaliser différentes tâches dont la construction d'une représentation de l'environnement, préservant les images appropriées, et d'apprendre comment regarder. Ces robots utilisent également leur mémoire pour atteindre les objets désirés même sans les voir réellement. «Nos résultats peuvent être appliqués à tout robot humanoïde capable de bouger ses yeux et de se concentrer sur un point», explique le chercheur espagnol. «Il s'agit de questions prioritaires pour que les autres mécanismes fonctionnent correctement.» Les autres partenaires d'EYESHOTS sont l'université de Münster en Allemagne, l'université de Bologne en Italie et l'université catholique de Louvain en Belgique.Pour de plus amples informations, consulter: EYESHOTS: http://www.eyeshots.it/ Université de Gênes: http://www.unige.it/

Pays

Belgique, Allemagne, Espagne, Italie