Extraire le signal du bruit: soutien aux personnes malentendantes

Les humains sont assaillis par une cacophonie de sons tout au long de leur journée. Même dans ces environnements riches en sons, ils peuvent localiser une source sonore pertinente sur le plan comportemental — comme la voix d’un ami dans une salle bondée — avec une précision remarquable. Nous savons peu de choses sur les mécanismes neuronaux qui sous‑tendent le calcul de la localisation spatiale de sons complexes dans des environnements bruyants. Par conséquent, les implants cochléaires (IC) ne parviennent pas à filtrer le signal au milieu du bruit. Cela désavantage les personnes malentendantes et réduit leur qualité de vie, notamment les possibilités d’emploi. Avec le soutien du programme Actions Marie Sklodowska-Curie (MSCA), le projet SOLOC a recouru à des méthodes informatiques et expérimentales pour mieux comprendre les mécanismes cérébraux de la localisation des sons. Ces résultats seront utilisés pour développer des stratégies de traitement du signal pour des IC capables de simuler le comportement humain de localisation des sons.

Le problème du rapport signal/bruit des implants cochléaires

Selon Kiki van der Heijden, titulaire d’une bourse MSCA et rattachée au Donders Institute for Brain, Cognition and Behaviour, coordinateur du projet, à l’Université Radboud, «en raison des limitations techniques des IC, des informations temporelles et spectrales cruciales sont perdues lorsque les signaux auditifs sont transmis au nerf auditif de l’utilisateur sous la forme d’une série d’impulsions. La représentation dégradée de la scène d’écoute qui en résulte est insuffisante pour que le cerveau puisse filtrer les sources sonores d’intérêt et supprimer le bruit de fond». L’efficacité des IC à percevoir la parole dans un fond silencieux ne se traduit pas par une perception efficace de la parole dans un environnement bruyant. «La recherche doit se concentrer sur les sons réels dans des scènes d’écoute écologiquement valides afin d’optimiser les stratégies de traitement du son pour les technologies d’assistance. Ainsi, la création d’une base de données de sons réels spatialisés, qui sera rendue publique pour soutenir d’autres recherches en neurosciences, en audition et en modélisation informatique, constitue un élément essentiel du projet», souligne Kiki van der Heijden.

Les réseaux neuronaux convolutifs inspirés par la neurobiologie soutiennent l’extraction de caractéristiques

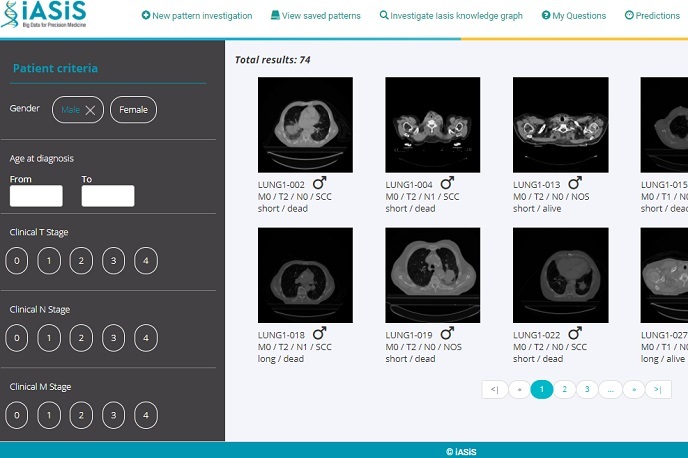

Le projet a mobilisé sa base de données et l’IA pour comprendre le traitement du son dans des scènes d’écoute réelles, connaissances qui seront utilisées pour optimiser les stratégies de traitement du son des IC. Les réseaux neuronaux profonds (RNP) sont des algorithmes formés pour apprendre une représentation des données à des niveaux d’abstraction croissants — ou à une «profondeur» croissante — comme le traitement par le cerveau. Cela leur permet d’effectuer des tâches complexes et de haute dimension telles que l’identification d’images ou la localisation de sons. L’apprentissage profond est devenu la référence absolue des algorithmes d’apprentissage automatique. Les réseaux neuronaux convolutifs (RNC) sont un type spécifique et très performant de RNP qui extrait des caractéristiques clés des données par une série d’opérations convolutives. «Nous avons développé un RNC inspiré de la neurobiologie et entraîné sur des sons réels de notre base de données. Nous avons démontré qu’il peut parfaitement simuler le comportement humain de localisation des sons. Nous avons également utilisé des enregistrements intracrâniens invasifs chez des patients neurochirurgicaux qui écoutaient un mélange de sons provenant de deux locuteurs séparés dans l’espace afin de mieux comprendre le traitement cérébral de la parole dans un environnement bruyant», déclare Kikii van der Heijden.

Des RNC aux IC: Un changement radical dans la localisation du son pour les malentendants

Le succès du projet confirme que les projets de recherche pluridisciplinaires à la croisée des neurosciences, de la modélisation informatique et de la recherche clinique sont cruciaux pour le développement de nouvelles technologies d’assistance. Le projet SOLOC a fourni des modèles informatiques biologiquement et écologiquement valides du traitement spatial des sons dans le cerveau humain. Il soutiendra l’optimisation d’algorithmes qui maximisent la disponibilité des repères spatiaux pour les personnes malentendantes, renforçant ainsi le pont que constituent les IC entre le cerveau et l’environnement.

Mots‑clés

SOLOC, son, IC, localisation du son, déficience auditive, implant cochléaire, RNC, réseau neuronal convolutif, RNP, réseau neuronal profond