Concevoir des machines qui voient, comprennent et interprètent leur environnement

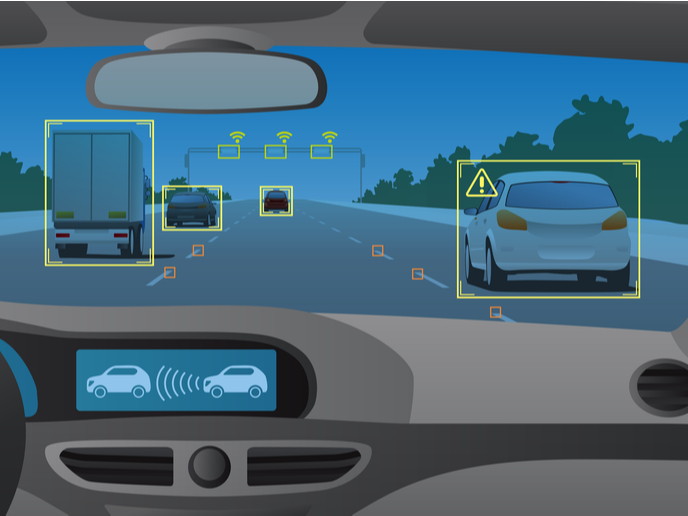

Imaginez un piéton collé à l’écran de son téléphone portable pendant qu’il traverse la rue, sans vraiment faire attention au feu rouge. Une voiture s’approche, son conducteur se sent peut-être un peu endormi à cause du manque de sommeil et n’est pas capable de s’arrêter immédiatement. Comment pouvez-vous éviter un accident dans une telle situation? Des systèmes avancés d’aide à la conduite (SAAC) aidant les conducteurs de véhicule à trouver leur chemin aux drones de recherche et de sauvetage, en passant par l’imagerie médicale par rayons X, les technologies de vision intégrée sont de plus en plus utilisées dans tout un éventail d’applications. Il s’agit d’intégrer la vision artificielle dans des machines qui utilisent des algorithmes pour décoder le sens des motifs de pixels observés dans les images ou les vidéos. Afin de pouvoir interpréter correctement leur environnement à l’aide d’entrées visuelles complexes, les systèmes de vision embarqués nécessitent une forte puissance de traitement. En plus des considérations liées à la consommation d’énergie, les concepteurs de ces systèmes intégrés doivent surmonter d’autres contraintes techniques ayant trait au coût, à la taille, au poids et au bruit acoustique. Le projet TULIPP, financé par l’UE, a relevé ces défis et mis au point une plateforme de référence pour les concepteurs de systèmes basés sur la vision. La solution TULIPP aidera «les concepteurs de produits de vision artificielle à relever facilement une série de défis: une faible consommation d’énergie, un faible temps de latence, des performances élevées et des contraintes de conception au niveau du traitement des images en temps réel», comme l’indique un communiqué de presse.

Des cas d’utilisation concrets

La plateforme de référence TULIPP se compose d’un kit de développement complet et de cas d’utilisation concrets. Le kit comprend «une carte informatique multicœur intégrée basée sur FPGA, un système d’exploitation en temps réel et en parallèle ainsi qu’une chaîne d’outils de développement avec des lignes directrices», d’après ce même communiqué de presse. Une matrice prédiffusée programmable par l’utilisateur (FPGA) correspond à un circuit intégré pouvant être programmé ou reprogrammé après fabrication, selon la fonctionnalité ou l’application requise . Les cas d’utilisation concernent «l’imagerie médicale par rayons X, les systèmes avancés d’aide à la conduite (SAAC) et les aéronefs sans pilote (UAV)». L’application en imagerie médicale par rayons X vise à améliorer l’efficacité chirurgicale dans le cas d’utilisation de l’arceau mobile. Ce dispositif affiche une vue interne du corps du patient en temps réel au cours d’une intervention chirurgicale, ce qui permet au médecin de pratiquer des incisions minimes avec une précision accrue. Cela permet d’accélérer les temps de récupération, «de diminuer les risques de maladies nosocomiales et de réduire de 75 % les doses de rayonnement auxquelles les patients et le personnel sont exposés», ajoute le communiqué de presse. Grâce à son application de détection des piétons, le cas d’utilisation SAAC «atteint un temps de traitement par image de 66 ms, ce qui signifie que l’algorithme remplit son objectif consistant à lire une image sur deux lorsque la caméra fonctionne à 30 Hz». Dans le cas d’utilisation concernant les UAV, TULIPP interprète les images de profondeur à partir d’une configuration où la caméra stéréoscopique est orientée dans la direction du vol. «Même si nous parlons de drones autonomes, la plupart des systèmes actuels sont encore pilotés à distance par des humains. Le cas d’utilisation utilise des cartes de disparité, calculées à partir des images prises par la caméra, afin de localiser les obstacles se trouvant sur la trajectoire de vol et de guider automatiquement le drone pour qu’il les évite. C’est le passage obligé pour obtenir des drones entièrement autonomes.» Le projet TULIPP (Towards Ubiquitous Low-power Image Processing Platforms), d’une durée de trois ans, s’est terminé en janvier 2019. Il s’est concentré sur le développement de systèmes embarqués très performants et économes en énergie, destinés au nombre croissant d’applications de traitement d’images, de plus en plus diverses et complexes, qui voient le jour dans un large éventail de secteurs industriels. Pour plus d’informations, veuillez consulter: site web du projet TULIPP

Pays

France